Apple prepara sus propios chips de inteligencia artificial para el iPhone 8

Según Mark Gurman, periodista de Bloomberg y uno de los mejor conectados con el mundo Apple, la compañía de la manzana está desarrollando sus propios chips de inteligencia artificial para el iPhone 8. Este chip se uniría a otros procesadores especializados del iPhone como el llamado coprocesador M que controla los sensores y los movimientos del móvil y serviría para realizar funciones como reconocimiento de imágenes o de voz.

Actualmente, estas funciones avanzadas del iPhone o las que realiza, por ejemplo Siri, se llevan a cabo de manera remota en los centros de datos de Apple, lo que significa que para utilizarlas necesitas tener conexión a Internet con una buena velocidad. Al integrar estas funciones en este chip del móvil, su respuesta puede ser mucho más inmediata y los sistemas remotos de Apple se pueden dedicar a otras tareas. Se cree que el chip de Apple se conoce internamente como Apple Neural Engine y permitirá que el teléfono tenga mejor autonomía al realizar estas tareas de forma más eficiente. Actualmente, las tareas que tienen que ver con estas funciones complejas se realizan con el procesador general (la CPU) o el sistema gráfico, lo que hace que el consumo sea muy superior.

Según Mark Gurman, Apple ya está probando prototipos del iPhone con este chip para inteligencia artificial incorporado dentro del A11, lo que lo pondría a la atura en este apartado de procesadores como el como el Snapdragon 835 de Qualcomm, que incluye el Hexagon DSP que realiza estas funciones (aunque algunas se derivan en la GPU o sistema gráfico) y se acompaña de un kit de desarrollo especial, el llamado Snapdragon Neural Processing Engine SDK.

Estos chips de inteligencia artificial son una evolución de los sistemas gráficos que habitualmente se usan también para hacer funcionar aplicaciones de inteligencia artificial, por su capacidad para realizar cálculos complejos o analizar grandes bloques de datos. Las CPU o procesadores convencionales no están tampoco bien preparados para estos cálculos de inteligencia artificial. Por ello se están desarrollando estos nuevos procesadores especialmente diseñados para ejecutar las llamadas redes neuronales o de aprendizaje profundo, que implican funciones como el reconocimiento del habla o de imágenes, traducción automática o funciones de robótica. Del mismo modo, estos procesadores se utilizan también en aplicaciones como la conducción autónoma o la realidad aumentada en la que tanto están invirtiendo compañías como Google o Tesla.

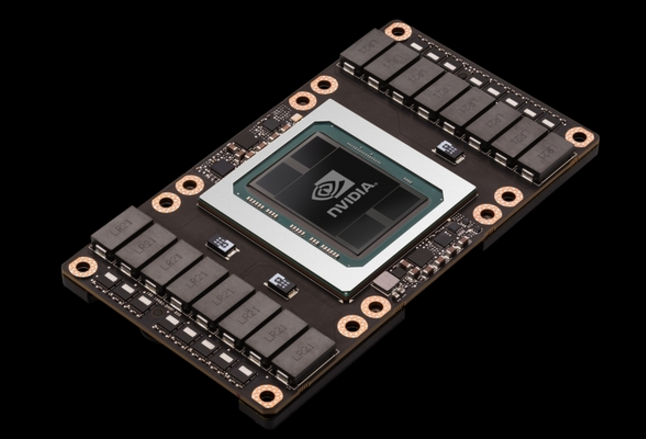

Google ha anunciado recientemente, por ejemplo que está fabricando estos chips especializados en inteligencia artificial, llamados TPU 2.0 que se instalarán en sus centros de datos para ofrecerlos como servicio para aplicaciones de inteligencia artificial en la nube, es decir, que podrán ser “alquilados” por cualquier compañía que quiera crear aplicaciones de este tipo y quiera contar con la potencia de hardware más adecuada para ello. Del mismo modo, otras compañías como Facebook, Tesla o Amazon están invirtiendo en sistemas de inteligencia artificial y fabricantes como Nvidia, tradicionalmente especializado en sistemas gráficos, también ha presentado sus procesadores Tesla V100 con 640 núcleos especializados en tensores que consiguen nada menos que 120 teraflops de rendimiento en inteligencia artificial (hace no muchos años un sistema capaz de rebasar un teraflop de rendimiento era considerado un supercomputador).